IA Responsable : concepts clés et bonnes pratiques

Sommaire

Face à l’expansion rapide de l’intelligence artificielle, la notion d’IA Responsable émerge comme une réponse aux enjeux cruciaux de sécurité, de fiabilité et d'éthique. Mais comment équilibrer innovation technologique et maîtrise des risques ? Pour approfondir cette thématique et agir concrètement, les équipes de BeTomorrow sont formées aux bonnes pratiques de l'IA responsable, garantissant ainsi la mise en œuvre de solutions vertueuses et maîtrisées dans chaque projet.

Dans cet article, nous vous partageons des solutions simples et concrètes pour respecter les principes de l'IA responsable.

Qu'est-ce que l'IA Responsable ?

L'IA Responsable fait référence à un ensemble de pratiques et de principes visant à garantir que les systèmes d'intelligence artificielle (IA) soient transparents, fiables et à même de limiter les risques et conséquences négatives potentielles. Ces principes doivent être appliqués tout au long du cycle de vie d'une application IA, depuis la phase de conception initiale jusqu'au développement, au déploiement, au suivi et à l'évaluation.

Pour exploiter l'IA de manière responsable, les entreprises doivent s'assurer que leur système :

Soit entièrement transparent et responsable, avec des mécanismes de supervision et de contrôle en place.

Soit gouverné par une équipe de direction chargée de la stratégie d'IA Responsable.

Soit développé par des équipes formées aux principes et pratiques de l'IA Responsable.

Soit clairement documenté afin de rendre les résultats des algorithmes facilement explicables.

Quels types d'IA sont concernées par les principes responsables ?

L'IA Responsable s'applique à tout type de système d'intelligence artificielle, qu'il soit basé sur des modèles d'apprentissage automatique traditionnels ou sur des modèles génératifs avancés.

L’IA Traditionnelle

Les modèles d'apprentissage automatique traditionnels exécutent des tâches spécifiques à partir des données d'entraînement fournies. Cela concerne par exemple la prédiction ou la classification, telles que l'analyse de sentiments et la reconnaissance d'images. Chaque modèle est limité à une tâche et nécessite un jeu de données représentatif et équilibré.

D'autres exemples : moteurs de recommandation, assistants vocaux, systèmes de détection de fraudes.

L’IA Générative

L'IA générative repose sur des foundation models (ou “FMs”), tels que les modèles de langage, pré-entraînés sur d'immenses volumes de données. Ces modèles polyvalents peuvent générer du contenu (texte, code, images…) en réponse à des instructions de l’utilisateur.

Exemple : chatbots, génération automatisée de code et création d'images.

Le potentiel des FMs est immense. Ils sont en train de transformer de nombreux aspects de notre travail au quotidien :

Créativité : production de nouveaux contenus (textes, images, vidéos, musique).

Productivité : automatisation de tâches répétitives et amélioration du rendement.

Connectivité : création de nouvelles formes d'interaction avec les clients et optimisation de la collaboration.

IA Responsable : les défis communs à l'IA traditionnelle et générative

La précision des modèles

Le principal défi auquel les développeurs sont confrontés dans les applications d’IA est la précision. Les applications d’IA, qu’elles soient traditionnelles ou génératives, reposent sur des modèles entraînés à partir de jeux de données. Ces modèles peuvent faire des prédictions ou générer du contenu uniquement sur la base des données sur lesquelles ils ont été formés. Si l’entraînement est insuffisant, les résultats obtenus seront inexacts. Il est donc essentiel de traiter les problèmes de biais et de variance dans votre modèle.

Les biais

Le biais est l’un des plus grands défis pour un développeur de systèmes d’IA. Un biais dans un modèle signifie que celui-ci omet des caractéristiques importantes des jeux de données, souvent parce que ces données sont trop simplifiées. Le biais se mesure par la différence entre les prédictions attendues du modèle et les valeurs réelles que l’on cherche à prédire.

Si cette différence est faible, le modèle présente un biais faible. Si cette différence est importante, le biais est élevé. Un modèle avec un biais élevé est sous-ajusté ("underfitted"), ce qui signifie qu’il ne capture pas suffisamment de différences dans les caractéristiques des données et, par conséquent, il obtient de mauvaises performances sur les données d’entraînement.

Exemple de biais dans la reconnaissance faciale : considérons un système de reconnaissance faciale entraîné principalement sur des images de personnes à la peau claire. Lorsqu'il est confronté à des visages de personnes à la peau plus foncée, ses performances diminuent significativement. Cette situation résulte d'un biais dans les données d'entraînement, où les individus à la peau foncée sont sous-représentés.

Une étude menée en 2018 a révélé que les systèmes développés par des entreprises majeures affichaient des taux d'erreur plus élevés pour les femmes à la peau foncée. Par exemple, un logiciel de Microsoft présentait un taux d'erreur de 20,8 % pour cette catégorie, contre seulement 0 % pour les hommes à la peau claire.

La variance

La variance représente un autre défi pour les développeurs. Elle fait référence à la sensibilité du modèle aux fluctuations ou au bruit dans les données d'entraînement. Un problème survient lorsque le modèle considère ces bruits comme des caractéristiques importantes. Une variance élevée indique que le modèle est devenu tellement familier avec les données d’entraînement qu’il peut produire des prédictions très précises, car il capture toutes les caractéristiques des données, y compris le bruit.

Cependant, lorsque l’on introduit de nouvelles données, la précision du modèle diminue, car celles-ci peuvent présenter des caractéristiques différentes non prises en compte lors de l’entraînement. Cela entraîne le problème du sur-ajustement ("overfitting"). Un modèle sur-ajusté fonctionne bien sur les données d'entraînement, mais échoue lors de l'évaluation sur de nouvelles données, car il a "mémorisé" les données vues au lieu de généraliser à des exemples inconnus.

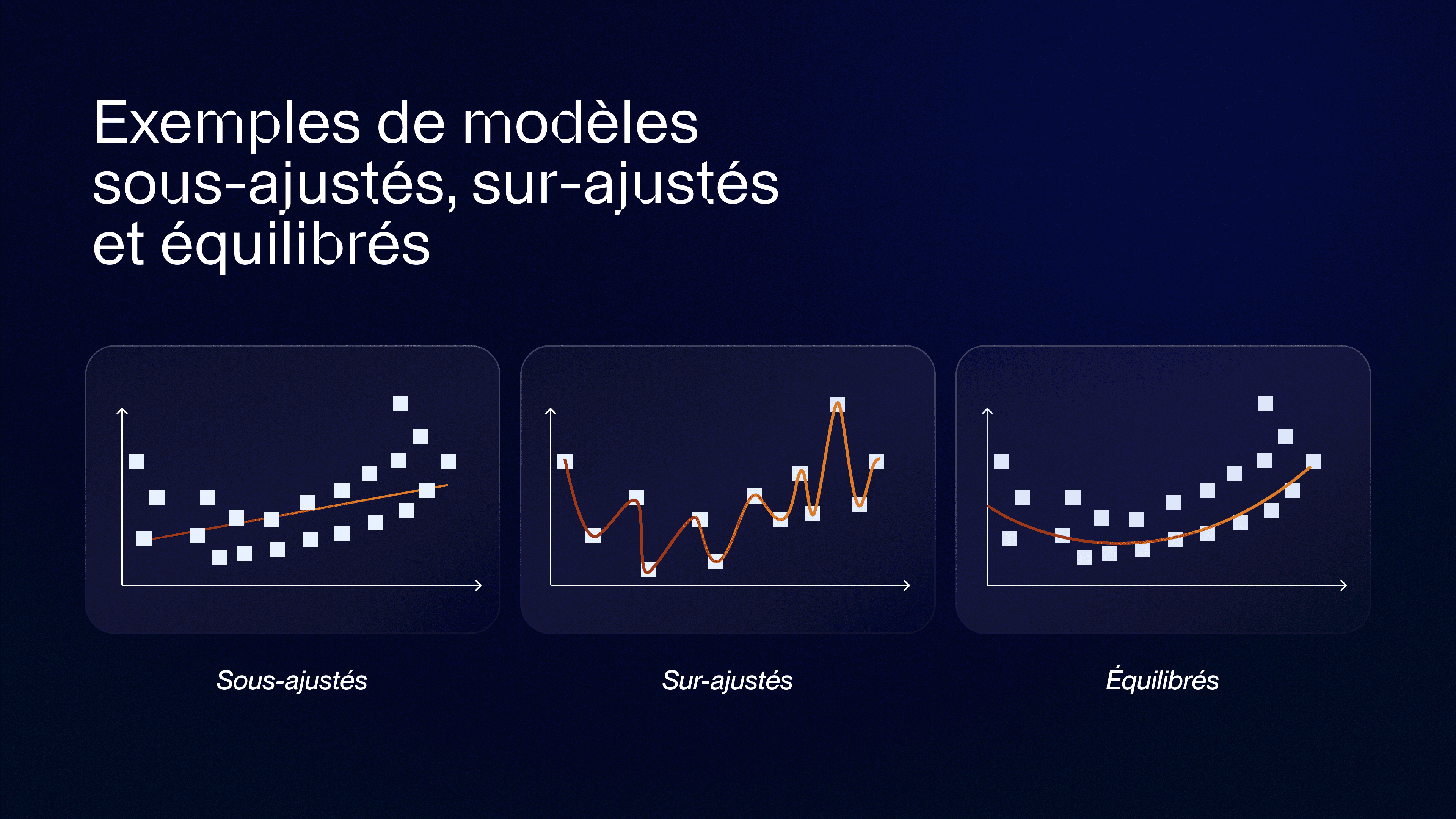

Le compromis biais-variance

Le compromis biais-variance consiste à trouver le bon équilibre entre biais et variance dans l’optimisation de votre modèle. L’objectif est d’entraîner un modèle qui ne soit ni sous-ajusté ni sur-ajusté, en réduisant autant que possible à la fois le biais et la variance pour un jeu de données spécifique.

Sous-ajusté ("underfitted") : le biais est élevé et la variance est faible. La régression se présente ici sous forme d'une ligne droite. Cela indique que le modèle ne capture pas suffisamment les caractéristiques des données.

Sur-ajusté ("overfitted") : le biais est faible et la variance est élevée. La courbe de régression épouse parfaitement les données, capturant même le bruit, ce qui entraîne une mémorisation excessive des données d’entraînement et de mauvaises performances sur de nouvelles données.

Équilibré ("balanced") : le biais est faible et la variance est faible. La courbe de régression capture suffisamment de caractéristiques des données sans être affectée par le bruit.

Voici quelques méthodes pour réduire les erreurs de biais et de variance :

Monitorer son IA en continu : déployer un modèle d'IA ne garantit pas de performances stables dans le temps. Un modèle peut dériver et générer des résultats inattendus, voire dangereux, si son comportement n'est pas continuellement surveillé. Prenons l'exemple d'un modèle dans la finance, en nous basant sur un algorithme de scoring de crédit initialement entraîné sur des données stables. Si, au fil du temps, les conditions économiques évoluent (inflation, changements de politique bancaire…) sans mise à jour des données d'entraînement, l'algorithme pourrait discriminer involontairement certaines catégories de demandeurs. Ce phénomène est appelé "data drift" : la distribution statistique des données d'entrée change par rapport à celle du jeu d'entraînement, entraînant des biais et des erreurs.

Effectuer de la cross-validation : c’est une technique qui permet d’évaluer les modèles de machine learning en entraînant plusieurs modèles sur des sous-ensembles des données disponibles et en les testant sur les sous-ensembles complémentaires. Utile pour détecter le sur-ajustement.

Augmenter la quantité de données : ajouter davantage d’échantillons pour élargir le champ d’apprentissage du modèle.

Appliquer la régularisation : cette méthode pénalise les poids extrêmes afin d'éviter le sur-ajustement des modèles linéaires.

Utiliser des modèles plus simples : cela permet de réduire le sur-ajustement. Si le modèle est sous-ajusté, il pourrait être trop simplifié.

Réduire la dimension ("ACP" ou "Analyse en Composantes Principales") : utiliser des techniques de réduction de dimensionnalité pour diminuer le nombre de caractéristiques dans un jeu de données, tout en conservant un maximum d’informations.

Arrêter prématurément l’entraînement : parfois, le fait de réduire le temps d'entraînement produit des meilleurs résultats. Des itérations successives sur les paramètres d'apprentissage (epoch, early stopping) sont nécessaires pour équilibrer le réseau de neurones.

Quels sont les défis spécifiques à l'IA générative ?

Tout comme l'IA générative offre des avantages uniques, elle présente également des défis spécifiques. Parmi eux : la toxicité, les hallucinations, les questions de propriété intellectuelle, le plagiat et la triche.

La toxicité

La toxicité désigne la production de contenus (texte, images ou autres) offensants, dérangeants ou inappropriés. Définir et circonscrire la toxicité s'avère complexe, car la subjectivité joue un rôle majeur dans la perception de ce qui est considéré comme toxique. La frontière entre la modération de contenus nuisibles et la censure est souvent floue et dépendante du contexte culturel. Par exemple, faut-il censurer des citations pouvant sembler offensantes hors contexte, même lorsqu'elles sont clairement identifiées comme telles ? D'un point de vue technique, la difficulté réside dans la détection de contenus offensants formulés de manière subtile ou indirecte, sans recours à un langage explicitement provocateur.

Les hallucinations

Les hallucinations désignent des affirmations qui paraissent plausibles, mais factuellement incorrectes. Étant donné le fonctionnement probabiliste des grands modèles de langage (LLMs) fondé sur l'échantillonnage de distributions de mots, ces erreurs sont particulièrement fréquentes dans les contextes factuels ou scientifiques. Un cas typique est la génération de citations scientifiques inexistantes. Par exemple, lorsque l’on demande à un modèle : « Cite-moi des articles de tel auteur », le modèle peut produire des références réalistes en apparence, mais inexistantes, avec des titres et des co-auteurs plausibles, mais fictifs.

La propriété intellectuelle

Les premières générations de LLMs ont posé des problèmes de respect de la propriété intellectuelle, car elles pouvaient reproduire des passages de texte ou de code identiques à leurs données d'entraînement, soulevant des questions de confidentialité et de droits d'auteur. Bien que des améliorations aient réduit ces occurrences, la génération de contenus inspirés de manière plus nuancée reste problématique. Par exemple, un modèle génératif d'images pourrait créer une œuvre d'un « chat en skateboard » dans le style d'Andy Warhol. Si l'œuvre est convaincante mais repose sur des données d'entraînement directement inspirées de Warhol, cela peut soulever des objections juridiques.

Le plagiat et la triche

Les capacités créatives de l'IA générative soulèvent des préoccupations quant à leur usage dans des contextes académiques et professionnels. Elle peut être utilisée pour rédiger des dissertations, des échantillons d'écriture pour des candidatures, ou encore des travaux évalués, facilitant ainsi la triche. Le débat reste vif, certaines institutions interdisant strictement l'utilisation de l'IA générative dans ces contextes, tandis que d'autres plaident pour une adaptation des pratiques pédagogiques. Le défi central reste la vérification de l'origine humaine d'un contenu.

La disruption du monde du travail

La capacité de l'IA générative à produire des textes et des images de qualité, à réussir des tests standardisés, à rédiger des articles ou à améliorer la grammaire de documents existants suscite des inquiétudes quant à son potentiel disruptif sur certaines professions. Bien que l'idée d'un remplacement généralisé semble prématurée, l'impact transformateur sur la nature du travail est indéniable, de nombreuses tâches auparavant non automatisables pouvant désormais être confiées à des systèmes d'IA.

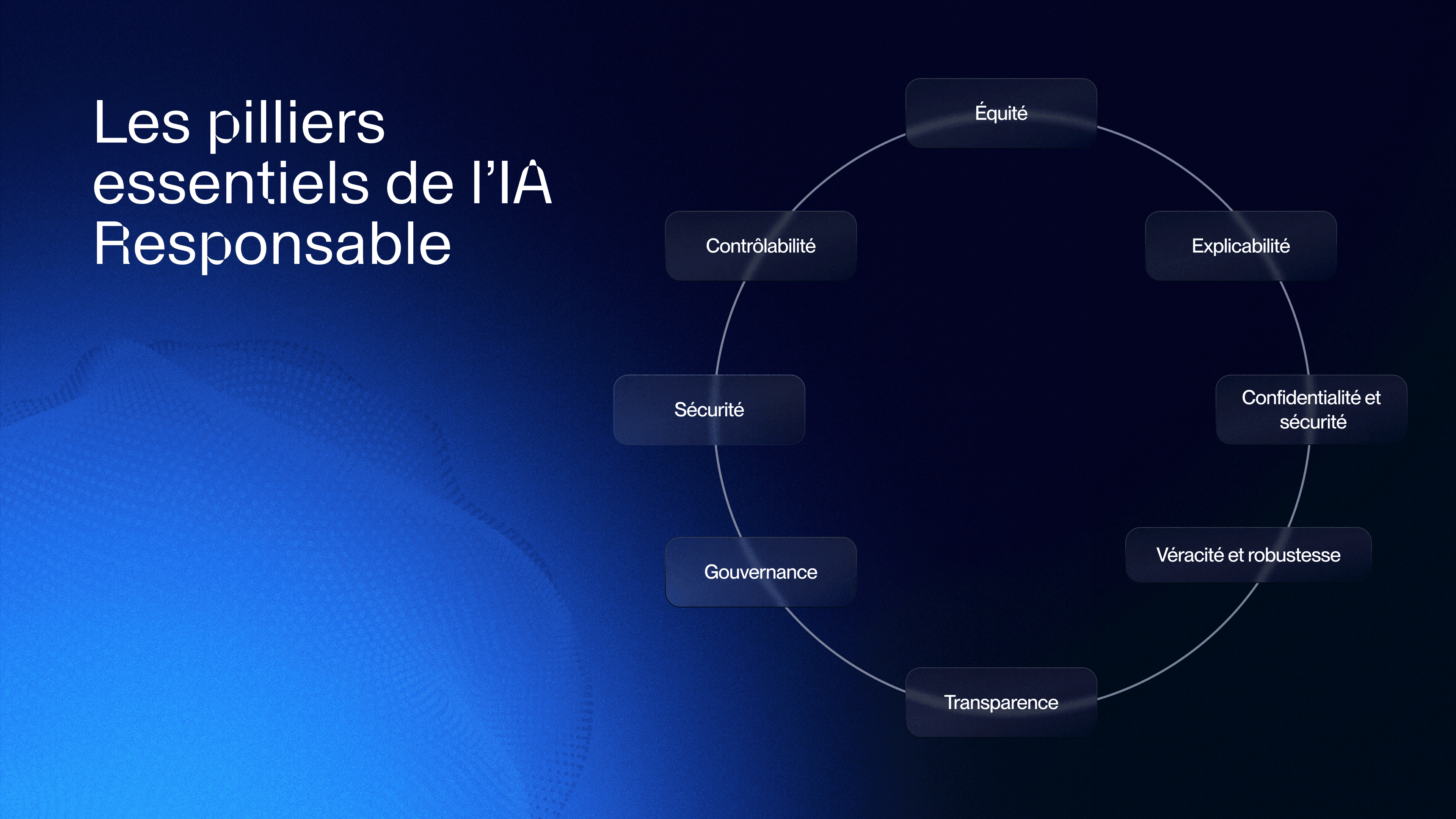

Les 8 principes fondamentaux de l'IA responsable

Les principes clés de l'IA responsable englobent l'équité, l'explicabilité, la confidentialité et la sécurité, la robustesse, la gouvernance, la transparence, la sécurité et le contrôle. Aucun de ces principes ne peut être isolé : ils sont tous interdépendants dans la conception d'une IA véritablement responsable.

L’équité

L'équité est essentielle pour garantir des systèmes d'IA inclusifs, prévenir les discriminations et respecter les normes éthiques et légales. Un système d'IA équitable favorise la confiance et évite les biais systématiques.

L’explicabilité

L'explicabilité désigne la capacité d'un modèle à justifier ses mécanismes internes et ses décisions de manière compréhensible par l'humain. Elle est cruciale pour détecter les biais, renforcer la confiance et corriger d'éventuelles erreurs d'interprétation.

La confidentialité et la sécurité

La confidentialité garantit que les utilisateurs conservent le contrôle sur l'utilisation de leurs données personnelles. La sécurité, quant à elle, veille à ce que ces données soient protégées contre tout accès non autorisé, assurant ainsi la confiance dans l'utilisation du système.

La transparence

La transparence implique de fournir aux parties-prenantes des informations claires sur le fonctionnement, les limites et les capacités d'un système d'IA. Elle permet de mieux comprendre les processus de décision, d'identifier les biais potentiels et d'assurer une utilisation éthique de l'IA.

La véracité et la robustesse

Un modèle robuste doit fonctionner de manière fiable, même dans des conditions imprévues ou face à des erreurs. Il doit rester précis et sûr, face à des variations de données ou de contexte, assurant ainsi la continuité de ses performances.

La gouvernance

La gouvernance de l'IA repose sur un ensemble de processus définissant, appliquant et contrôlant les pratiques responsables au sein d'une organisation. Elle garantit le respect des droits, des lois et des normes éthiques, comme la protection de la propriété intellectuelle et la conformité réglementaire.

La sécurité

La sécurité dans l'IA responsable implique la conception de systèmes qui minimisent les risques de biais, d'erreurs et de conséquences imprévues, protégeant ainsi les individus et la société.

La contrôlabilité

La contrôlabilité fait référence à la capacité de superviser et d'ajuster le comportement d'un système d'IA afin qu'il demeure aligné sur les valeurs et les intentions humaines. Un modèle contrôlable facilite la gestion des dérives et contribue à la transparence et à l'équité.

Conclusion

Alors que des outils IA comme Grok illustrent les dérives possibles de l’intelligence artificielle lorsqu’elle est déployée sans garde-fous, il est plus que jamais crucial de définir un cadre éthique et responsable pour cette technologie. L’IA Responsable ne doit pas être un simple slogan, mais une démarche proactive intégrant transparence, inclusion et réflexion sur les impacts sociaux. Des initiatives comme le projet de loi sénatorial canadien, visant à encadrer l’usage de l’IA dans les administrations publiques pour garantir transparence et équité, offrent un exemple concret de réponse à ces challenges.

Le défi reste immense : comment concevoir une IA qui amplifie les opportunités tout en limitant les risques ? Les réponses résideront dans une collaboration accrue entre les entreprises, les chercheurs, les gouvernements et la société civile.